こんにちは。Eight事業部でiOSエンジニアをしています アマゾネス です。

東京で開催された try!Swift というカンファレンスに参加して、すごく大事な話を聞いたので共有します。

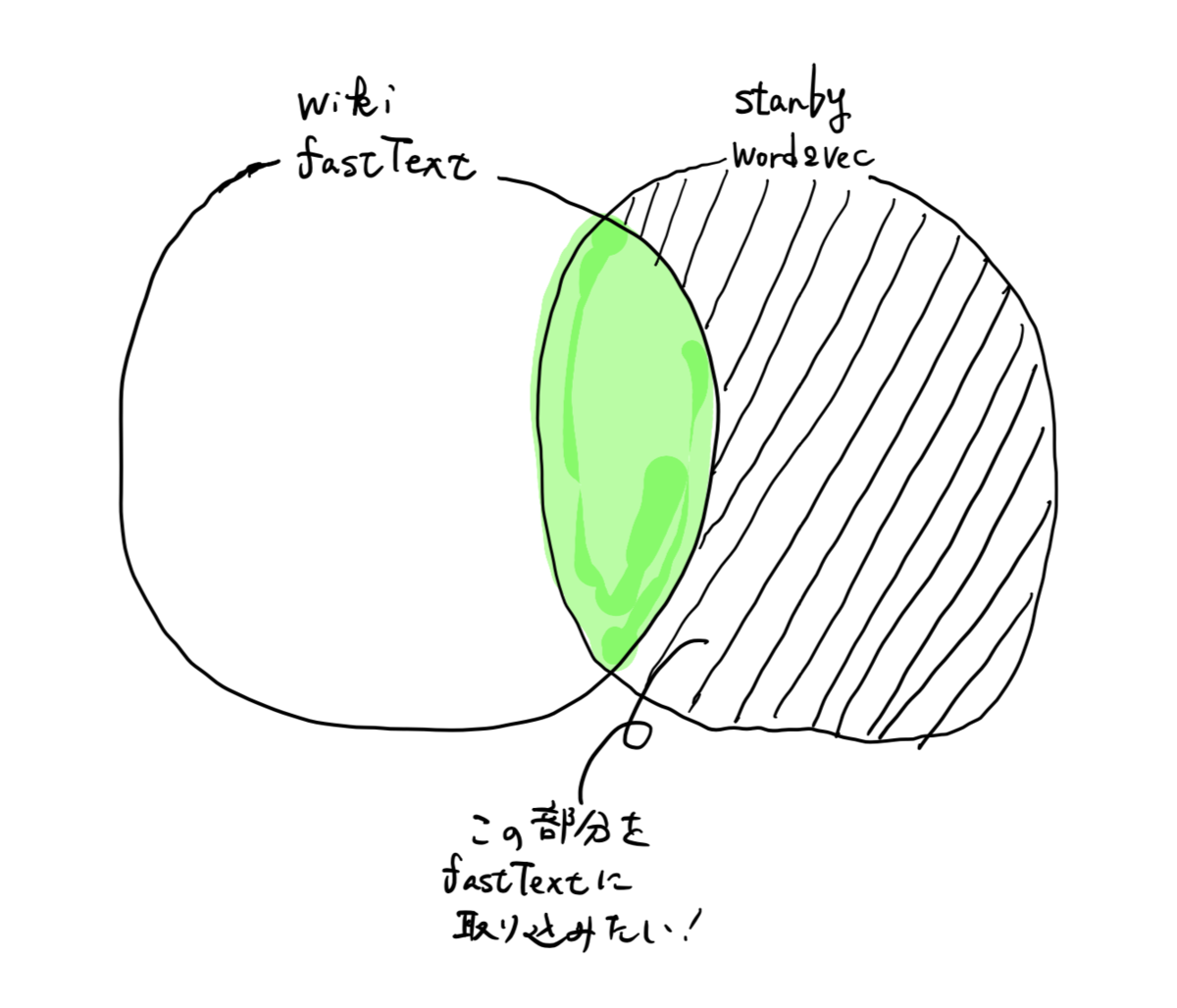

try!Swiftとは?

try! SwiftはSwift言語での開発における最新の応用事例について集まる国際コミュニティです。このイベントは世界中から人々が集まり、Swiftのスキルを向上させるための、高度な知識やテクニックを共有し、協力しあうことを目的としています。

TOKYO - try! Swift Conference から引用

Swift は、2014年に apple から発表されたプログラミング言語で、主に iOS、MacOS のアプリケーションを作ることに使用されています。私はiOS版の Eight を実装するために、Swift を書いています。

Female YouTuber Mayuko Inoue

技術系のお話がほとんどかと思ったのですが、「Developerとして」というような技術から少し離れたお話もいくつかありました。「次へつなごう— Extending a hand to the next generation of Apple developers」 がとても心に残ったので、その内容についてお話をしたいと思います。

iOSエンジニア📱 Youtubeでテック業界で働くエンジニアとしての生活について動画も作ってます。 🇺🇸生まれ、🇺🇸育ちの二世の関西弁訛りの日本人です。

helloMayuko_jp (@helloMayuko_jp) | Twitter より

現在は Netflix でiOSエンジニアとして働かれているそうです。

彼女自身の1日の様子を収めた動画↓がとても有名です。

VIDEO www.youtube.com

開発者の多様性について

彼女は過去、エンジニアへの応募に人種的な多様性がないことを疑問に思い、自身の Twitter でモバイルエンジニア、特にiOSのエンジニアが少ないのは何故かと言うことを問いかけたそうです。

開発するためのPCが高い、モバイル端末が高い、など金銭面に関わることや、どうやってなればいいのかわからない、などのレスポンスがあったそうです。

次の世代の開発者のために今の開発者ができること

Diversity (多様性) が謳われる現代において、特定の人々で作るプロダクトよりも、様々な人で作った方がより良いプロダクトになるはずである、そのような状態を実現するために、Mayukoさんは以下の二つの提案をされていました。

- イメージを作る

自分のしたいこと、自分にしかできないこと、など自分自身が持つ多様性 と向き合い、そこからどのようなことができるかイメージを作りましょう、ということかと、私は思います。具体的な例として「プログラミングを教える 」「自分の知識を共有する 」などがあげられていました。イメージをつくることによって、次の世代に繋げるための、行動が生まれるのではないでしょうか。

- あなたのことをしってもらおう

文字通り、開発者である自分のことを発信することによって、色んな人に開発者ってこんな感じなんだ! ということを知ってもらおうということ。知る、ということは、興味を持つきっかけにもなるし、開発者になりたい人への参考にもなりますので、間口が広がるでしょう。

私が考えたストーリーと感じた事

既に開発者である私たちが行動する → 色んな人に開発者になるチャンスが生まれる → 開発者になる → 様々なプロダクトが生まれる → 沢山の人が喜ぶ!

補足:

Mayukoさんの登壇の様子は後日 try Swift! の YouTubeチャンネルでシェアされるそうです! また、登壇の内容を文章にしてくださっている方がいらっしゃいました! 本当に感謝です。シェアさせていただきます。

次へつなごう— Extending a hand to the next generation of Apple developers | try! Swift Tokyo 2019 2-16 - niwatakoのはてなブログ