こんにちは。 DSOC R&D グループの高橋寛治です。

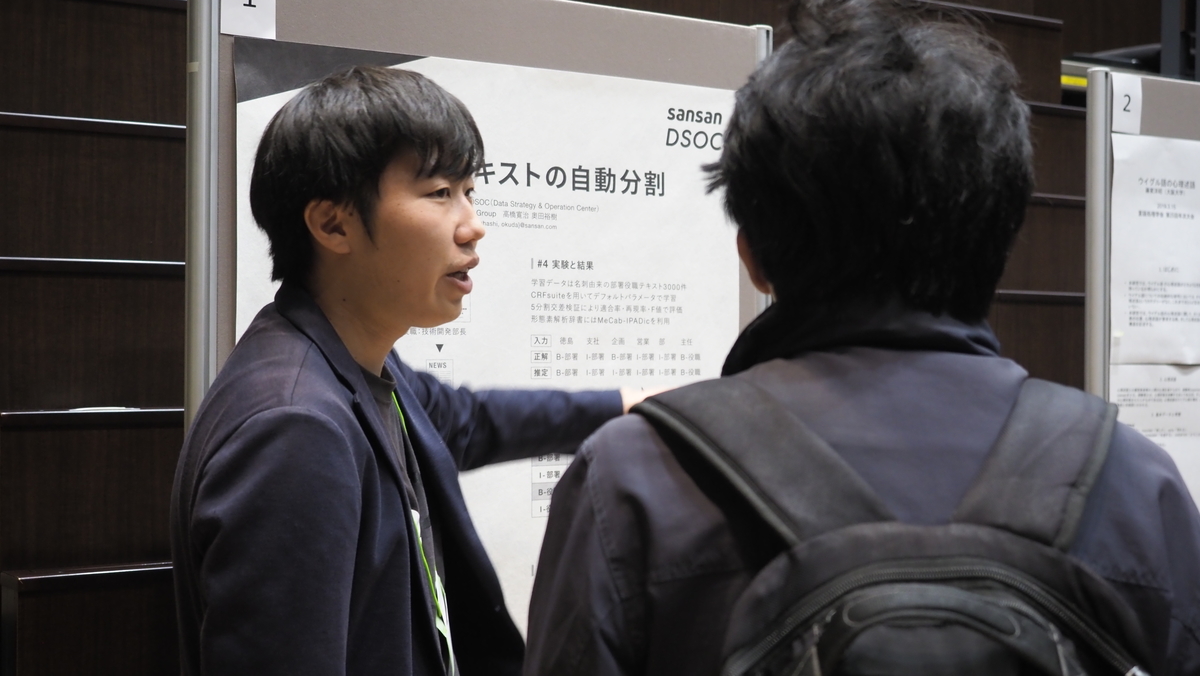

2019年3月12日から15日にわたり開催された言語処理学会第25回年次大会に参加し、ポスター発表を行いました。

本記事は、参加報告および発表内容の紹介となります。

言語処理学会第25回年次大会

言語処理学会が開催している年次大会で、国内の言語処理の研究者が一堂に会する年に一度のイベントだと言っても過言ではありません。 毎年3月の2〜3週目におおよそ1週間にわたって発表や講演があり、また懇親会や若手の会など、勉強だけでなく研究者間の交流も深められる非常に有意義な会です。

私は学生の頃から参加させていただいており、今回は6回目の参加となります。 昨年度の奥田による参加報告はこちらをご覧下さい。

今年度も昨年に引き続きプラチナスポンサーとして、ブース出展やスポンサーイブニングなどでお話しする機会をいただきました。

NLPは交流が盛んな学会で、今年ひときわ印象に残ったのは研究者間でのNLP Splatoonでした。 学会発表はもちろんのことですが、来年もNLP Splatoonには参加したいと思います。 (Splatoonについても皆さん研究熱心でした 笑)

発表内容

「部署役職テキストの自動分割」というタイトルで発表いたしました。

研究の概要は、部署と役職に関しては構造化されておらず連続した文字列(以降、部署役職テキストと呼ぶ)となっているため、これを分割するというものです。 特別新しい手法の提案ではなく、部署役職テキストに対して分割を行った結果の報告です。

よくある手法である系列ラベリングを用いて、部署役職テキスト中のトークンが部署か役職かをタグ付けします。

実際にはIOB2タグ(Inside-outside-beginning)と呼ばれるタグの推定を行います。

例えば、 B-部署 といったようなタグです。

結果、部署と役職が正確に分割されるのは 78% でした。

たくさんの人にお越しいただき、ポスター内容について議論することができ非常に良い機会でした。 特別な手法を使っているわけではないため、同様の手法で別タスクを解いたときの知見を聞けたり、CRFを使うのではなくルールベースでどこまでできるかなど、今後を考える上での様々な課題が浮かび上がりました。 現在の取り組みを共有することで様々な意見をいただけるのは、本当に嬉しく、学会に参加できてよかったと感じます。

学会で発表するときっといい

学会でたびたびお会いすることのあるGunosyの関さんに「学会で企業研究をアピールしていこう!」と言われたことを非常によく覚えています。 今回の発表では、企業側が持つ課題を学術側にアピールできたのではないかと思います。

今後もこのような活動を続けて、産業界の課題とその向き合い方について発表していきたいと思います。

執筆者プロフィール

高橋寛治 Sansan株式会社 DSOC (Data Strategy & Operation Center) R&Dグループ研究員

阿南工業高等専門学校卒業後に、長岡技術科学大学に編入学。同大学大学院電気電子情報工学専攻修了。在学中は、自然言語処理の研究に取り組み、解析ツールの開発や機械翻訳に関連する研究を行う。大学院を卒業後、2017年にSansan株式会社に入社。現在はキーワード抽出など自然言語処理を生かした研究に取り組んでいる。