はじめに

こんにちは、DSOC研究開発部の橋本です。最近買ってよかったな、と思ったものは「詰め替えそのまま」です。これはシャンプーやトリートメントの詰め替えをそのままホルダーにかけて使うことができるようになるグッズで、文字通り(比較的安い)詰め替えをそのまま・簡単に使えるようになる点、お風呂の床に詰め替えを置かなくて済むようになる点という2つの点から非常に良いです。気になる人はぜひググって買ってみてください。

詰め替えそのままの話はさておき、今回時間依存性を考慮したword embeddingsの話をします。

時間に依存するword embeddingsの必要性

現在では、word embeddingsはもはや一般的なツールになりつつあると思います。学習済みのword embeddingsを適用して特徴量とし、何かしらの機械学習アルゴリズムにかける、というのもよく行われていると思います。しかし、過去の学習済みのword embeddingが現在のテキストにもそのまま適用できるか、と言われると、そうでない単語もあると思われます。例えば、コロナ禍以前では「コロナ」という単語は飲料品の文脈などで出ることが多いと思われますが(少なくとも、昔は病気の文脈では数多くは出てこなかったでしょう)、現在は完全にウイルス・疫病の文脈で出現するようになっています。このように、何らかの出来事や時代の変化によって文脈が変わる単語は一定数存在します。したがって、時間依存性を考慮したword embeddingsを得られると、特に最新のテキストを解析する場合には通常の学習済みモデルを使う場合より性能が良くなることがあると考えられます。

word embeddingsの時間依存性を考慮するにあたって、一般的には各時間ごとにword embeddingsを得る方法が主だったようです[1]。しかし、word embeddingsは一般的にnon-convexな学習のため、学習のたびに結果が異なります。そのため、時間ごとのembeddingsの違いを見ようとしたときに、それが本当に時系列推移のシグナルなのか、学習ごとに結果が異なるために生まれるノイズなのか区別がつかない、という問題が発生します。したがって、word embeddingsに時間依存性を導入する際には、モデル・定式化の時点で時間依存性を仮定した上で一括で学習を行うようにすると、より厳密にword embeddingsの時間依存性を捉えられると思われます。

word embeddingsに時間依存性を仮定したモデルはいくつか提案されていますが、今回は主な3つのモデルについて紹介していきたいと思います。

アルゴリズム

Dynamic Word Embeddings (2017)

2017年に発表されたDynamic Word Embeddings [2]では、時間依存するword embeddingsを推定するために2種類の推論方法を提案しています。word embeddingsに時間変化を導入するため、カルマンフィルタ的な取り扱いを行っているのが特徴です。

まずは確率モデルとして、時間に依存するembeddingsを考えてみたいと思います。embeddingsの次元数を、総単語数を

、時間ごとのword embeddingsを

とし、対応する時間ごとのcontext embeddings を

と置いて定式化を考えます。

単語とcontext のペアを とすると、その

ペアがコーパスに存在した(しなかった)回数

は上記のembeddingsで以下のようにおけます。

これに、と

の時間変化を記述する式を置けばよいです。embeddings

、

の時間推移は

対応する同時分布は

となります。

ここで欲しいのは時間に依存するembeddings と

なので、事後分布

が求めたいものになります。しかし、実際に計算する際に必要になる積分項

がintractableなので厳密には求められません。ここでは、Dynamic Skip-Gram Filtering (DSG-F)と、Dynamic Skip−Gram Smoothing (DSG-S)という2つの提案法において、それぞれ近似事後分布を仮定しています。

DSG-Fでは、時間 におけるembeddingsの近似事後分布を、以下のように仮定します。

ここでと

は最適化したい変分パラメータです。あくまでも時間

におけるembeddingsの事後分布であるため、時間方向に対して完全に分解されている(独立を仮定している)ことが特徴です。

DSG-Sでは、

と近似事後分布を仮定します。ここで最適化したい変分パラメータはと

です。 DSG-Sの近似事後分布はDSG-Fとは対照的に、時間方向に対しての依存性を仮定しているのが特徴です。変分パラメータの詳細な更新式や全体のアルゴリズムは元論文[2]を参考にしていただきたいですが、いずれの

についても最適化することでそのまま時点

におけるembeddings (の平均)を得られるため、初期値には学習済みのembeddingsを使用することができます。

DSG-Fでは時間方向は完全に因子分解を仮定していますが、DSG-Sでは時間方向の依存性を仮定しているということもあり、傾向としてはDSG-Sを用いた方がより予測尤度が高いembeddingsの近似事後分布となります。

Dynamic Embeddings for Language Evolution (2018)

Bleiらによって提案された手法であるDynamic Bernoulli Embeddings [3]ではword2vecの分散表現にGaussian Random Walkを仮定します。具体的に言うと、分散表現自体を時間依存する連続潜在変数として扱い、単語がそれに従い生成される、というモデリングを行います。分散表現を連続潜在変数とするモデリング自体は、Exponential Family Embeddings[4]という2016年に提案されたモデルの特殊な場合ではあるのですが、これに時間依存性を組み込んだのがDynamic Bernoulli Embeddingsです。

まずは以前に提案されたExponential Family Embeddingsに倣い、普通のword2vecを確率モデルとして考えてみます。ここではword2vecの中でも、周辺単語集合から該当単語を予測するcontinuous bag of words (以下CBoW)を確率モデル化したいと思います。系列 における

番目(

)の単語

(

次元のone-hotベクトル)において、

番目の単語が

であるかどうかはBernoulli分布で表現することができます。

ここでは

番目の単語が

である確率です。この

を直接推定したくなるのですが、推定時に

]の制約を無くすため、代わりに対数オッズ

に変換し、この

を推定することにします。

実際に推定を行うために、embedding vector という

自体の埋め込みと、context vector

という周辺の文脈を埋め込むベクトルを定義し、次の形式で書くことにします。

この式では、指定した単語 自体の埋め込みと、

の周辺単語の埋め込みベクトルを足し合わせたベクトルの内積をとっており、オッズとして考えても直観的な式かと思います。この

の形式自体はExponential Family Embeddingsの中で提案されていて、上記の

と

を学習することで、確率モデル化したword2vecを学習できる、ということになります。ここまでの内容はExponential Family Embeddingsで提案されたモデルの特別な場合(Bernoulli分布)です。

先程まででCBoWのword2vecを確率モデル化できたので、時間依存性を組み込んだDynamic Bernoulli Embeddingsを説明していきたいと思います。

といっても非常に簡単で、embedding vectorが時間によって異なる ( →

)と仮定した上で対数オッズを求め、さらにembedding vectorがGaussian Random Walkする、と仮定すればよいです。

ここで、

は精度パラメータです。

グラフィカルモデルはこのように書けます。embedding vectorは時間依存、context vectorは時間に依存しないものとし、これらから系列 が生成されるというイメージです。

目的関数ですが、

と3つの項からなります。ここで

です。 はword2vecにおける正例に該当し、

は負例に該当します。通常の時間に依存しないword embeddingsを得る際と同様に負例の近似を行いたい場合はNegative Samplingを用いることができます。その場合

は

と、Negative samples を用いて計算してあげればよいです。

の項は正則化の役割を担っています。特に Eq. (14)の第二項が特徴で、一時刻前との差のノルムをとっています。これによって、

が急激に変化し"すぎる"のを防ぐ役割があります。

以上の目的関数を、時間ごとのembedding vector と context vector

をパラメータとして最適化させることで、時間依存したembeddingsを得られます(元論文ではAdagradを用いていました)。

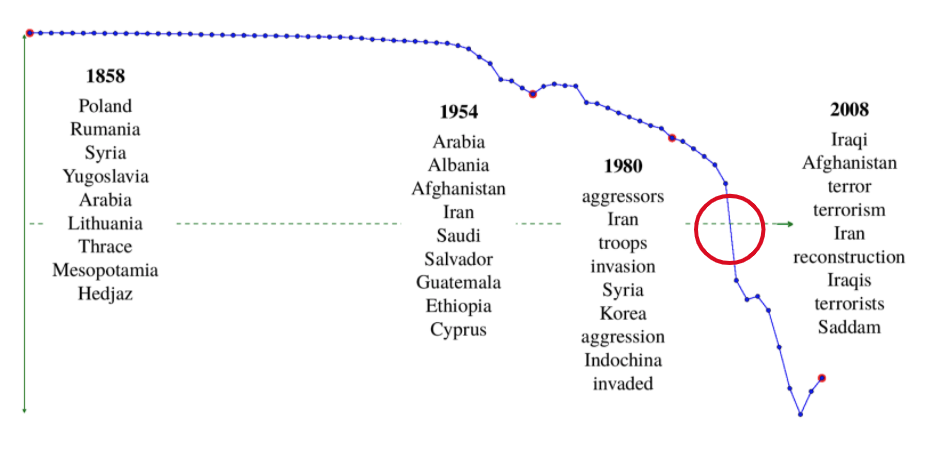

簡単に結果を示したいと思います。アメリカ上院議会のスピーチにおいて"IRAQ" という言葉の文脈変化を示したのが下の図です。横軸が時間、縦軸がの第一主成分なのですが、赤丸の部分(1990-1992)年に最も急峻な変化を示していることがわかります。実際に1990年には湾岸戦争が勃発しており、納得感のある結果かと思います。また、1858年、1954年、1980年、2008年における"IRAQ"の周辺に特に出現した単語も示されていますが、実際に戦争に関連する語が現れており、社会の状態を反映していると言えます。

Dynamic Word Embeddings for Evolving Semantic Discovery (2018)

この論文で提案された手法[5]では、時間ごとに正の相互情報量 (Positive Pointwise Mutual Information, PPMI) 行列を設計し、それを行列分解するアプローチによって各時間ごとのembeddingsを求めています。PPMIは次の式で定義されます。

、

はそれぞれ

、

の生起確率、

は

と

が同時に生起する確率を表しています。つまり、独立を仮定した場合と比較してどれだけ共起する確率が高いか・どれだけ関連性が高いかを示す尺度になります。

をとっているのは、共起する回数が0の場合

となるのを防ぐためです。

時間におけるPPMI行列を

、時間ごとのembeddingを

とおくと、最適化したい目的関数は以下のように設計できます。

ここで、、

は正則化パラメータです。第1項はPPMI行列の復元、第2項はembeddingsの正則化、第3項は[4]の目的関数と同様に

の急激な変化を抑えるための項となります。

以上の目的関数を で最適化すれば、各時間ごとのembeddings

を求めることができます。

こちらの論文も、簡単に結果の一部を示したいと思います。以下のテーブルは、あるクエリに対し当時のどのような単語に近いかというものを示しています。これを見ると、例えばtwitterは昔のblogやchatに近いということを意味しており、納得感のある結果かと思います。

まとめ

今回は、時間に依存したWord Embeddingsのアプローチについていくつか論文を交えて紹介しました。どの論文でも、時間ごとに学習すると学習由来のノイズと時系列推移の区別がつかない・より厳密にword embeddingsの時間依存性を捉えたいというところに課題感を抱えた上で提案された、という部分は同じでしたが、そこからの定式化・アプローチはそれぞれ全く異なっていたのが非常に興味深かったです。

これらの手法の定量的な評価においては、[2]・[3]では予測尤度、[5]ではNMI (Normalized Mutual Information) などの指標において、時間に依存しない通常のword embeddingsを上回っていました。一方で、定性評価についてはいくらか図で示しましたが各論文でかなり多様性があり、[2]においては他の単語との類似度の時間変化、[3]では指定した単語周辺の文脈の時間変化やその時間変化が大きかった時点、[5]では指定した単語が昔のどのような単語に該当するか(あるいは近いか)などを調べていました(個人的には、論文[3]は定式化もシンプルで定性評価も結果がはっきりしており、素晴らしいなと思いました)。

今回紹介した方法で得られるembeddingsに対してこれらの定性的な評価方法を相互に適用してみると、それぞれのembeddingsの得意なことや苦手なことが分かり面白いのではないかと思います。

参考文献

[1] Vivek Kulkarni, Rami Al-Rfou, Bryan Perozzi, and Steven Skiena, "Statistically Significant Detection of Linguistic Change", in WWW, 2015.

[1411.3315] Statistically Significant Detection of Linguistic Change

[2] Robert Bamler, Stephan Mandt, "Dynamic Word Embeddings", in ICML, 2017.

[1702.08359] Dynamic Word Embeddings

[3] Maja Rudolph, David Blei, "Dynamic Embeddings for Language Evolution", in WWW, 2018.

https://dl.acm.org/doi/10.1145/3178876.3185999

[4] Maja R. Rudolph, Francisco J. R. Ruiz, Stephan Mandt, David M. Blei, "Exponential Family Embeddings", in NIPS, 2016.

[1608.00778] Exponential Family Embeddings

[5] Zijun Yao, Yifan Sun, Weicong Ding, Nikhil Rao, Hui Xiong, "Dynamic Word Embeddings for Evolving Semantic Discovery", in WSDM, 2018.

[1703.00607] Dynamic Word Embeddings for Evolving Semantic Discovery