こんにちは、Strategic Products Engineering Unit SRE Groupの辻田です。2025年4月にラスベガスで開催されたGoogle Cloud Next 25に参加してきました。

本記事では、Google Kubernetes Engine (GKE)に関する最新アップデート情報と、私が参加したGKE関連のセッションについて共有したいと思います。

準備編の記事はこちらです。

【Google Cloud Next 25】ラスベガス出張のパッキングと参加予定セッション - Sansan Tech Blog

GKE関連のアップデート情報

GKEは今年で10周年を迎えるようです。AI/MLワークロード向けの新機能が多い印象でした。気になったアップデート情報をピックアップして紹介します。

1. GKE Inference Gateway(Preview)

LLM推論ワークロードに最適化されたインテリジェントな負荷分散が可能になりました。これにより、LLMを使用したアプリケーションのパフォーマンスが向上し、コスト効率の改善も期待できます。

2. GKE Inference Quickstart(Preview)

AIモデルと希望するパフォーマンスを選択するだけで、GKEが適切なインフラストラクチャ、アクセラレータ、Kubernetesリソースを自動的に構成できます。

3. Cluster Director(GA)

クラスタのデプロイや複雑な管理を支援する機能が一般提供(GA)されました。クラスタに属するノード上で実行されているジョブが確認でき、ノードの正常性確認も自動で行われ、問題が起きた場合の修復を支援する機能です。これにより、複数のGPUをGKEやSlurmで管理することが容易になります。 また、今後はGKEやSlurmといったオーケストレータを指定し、UI上からクラスタがデプロイ可能となる予定みたいです。

4. パフォーマンス重視のHPA profile(GA)

Performance HPAプロファイルがGAとなり、1.32.1-gke.1729000 以降のGKE Autopilotクラスタではデフォルトで適用されるようになりました。HPAの計算速度が3倍に向上したとのことです。これにより、自動スケーリングの信頼性とパフォーマンスが向上します。

5. Container-optimized Autopilot(Roadmap)

GKE Autopilotが提供するリソース最適化の機能がすべてのGKEクラスタで適用可能になるようです。GKE Autopilotのリソース最適化機能を既存のGKEスタンダードクラスタでも利用できるようになります。これにより、コンピューティングリソースコストの削減が期待できます。

他のアップデート情報や詳細は公式のGoogle Cloud Next 25のrecapを参照してください。

参加したセッションのハイライト: Tackle the complexities of managing GKE at scale

Tackle the complexities of managing GKE at scale

現地ではWorkshopやMeetupへの参加を優先していたため、GKE関連のセッションはこちらのみ参加できました。 このセッションでは、大規模なGKEの運用管理に関する課題とその解決策、AI/MLワークロードの効率的な運用手法が紹介されていました。

スケーラブルなAI基盤の構築には何が必要か?

AI/MLの活用が進む一方で、GPUリソースの逼迫や高騰するコスト、チームごとにバラバラなクラスタ運用など、GKEをスケーラブルに使いこなすにはいくつかの壁があります。

このセッションでは、それらの課題に対する実践的な解決策として、「Fleetベースのクラスタ管理」 と 「ワークロードに最適化されたスケーリング戦略」 が紹介されました。

Fleetで実現するマルチクラスタ・マルチチーム管理

Fleetは、複数のGKEクラスタをひとつの論理的な単位として扱える仕組みです。プロジェクトやチームを跨ぐ環境であっても、統一されたガバナンスとセキュリティ管理が可能になります。

- チーム単位でアクセス制御やポリシーを適用

- クラウド/オンプレ問わず一貫した運用が可能

- Anthosとの親和性も高く、ハイブリッド環境にも対応

ワークロードに応じたスケーリングとコスト最適化

生成AIなどのワークロードにおいては、リソースの柔軟なスケーリングとコスト効率が不可欠です。

GKEは次のような戦略を支援しています。

- 4次元オートスケーリング:CPU/メモリ/GPUだけでなく、カスタムメトリクスも考慮して自動調整

- コスト効率の高いVMオプション:Spot VM、T2D VM、マルチインスタンスGPUなど

- 最大65,000ノードまでサポート:大規模モデルの学習にも対応可能

Dun & Bradstreetの事例紹介

データ企業のDun & Bradstreetは、GKEをベースに生成AIの基盤を構築し、複雑なマルチクラスタ構成をFleetで一元管理しています。インフラのスケーリング、セキュリティー、コスト管理までを高いレベルで実現しており、実際の構築・運用プロセスが共有されました。

まとめ

われわれが開発しているPlatform Orbitの全社展開を後押しするような新機能が多く発表されました。特に、HPAのパフォーマンス向上は嬉しいニュースです。Podのスケーリングの遅延は課題でしたが、改善が期待できます。これにより、Orbitの展開が進めやすくなることを期待しています。

ブレイクアウトセッションでは、大規模なGKEの運用管理に関する内容を聞けて、Orbitが成長していく上でのヒントを得ることができました。今後Orbitの規模が拡大したときにマルチクラスタへの移行が必要になるかもしれませんが、Fleetを活用すれば複雑性を軽減できると感じました。Fleetでは共通の構成やセキュリティーポリシーをマルチクラスタに同期・適用できたり、クラスタを跨ぐとロードバランシングが可能になったりします。

また、AI/MLワークロードのスケーラビリティーとコスト最適化に特化した新機能を提供しており、複雑なデプロイメントやリソース管理の課題を解決し、効率的な運用が可能になりました。今後はAI/MLワークロードもPlatformに乗せられるよう、力を入れていきたいと思います。

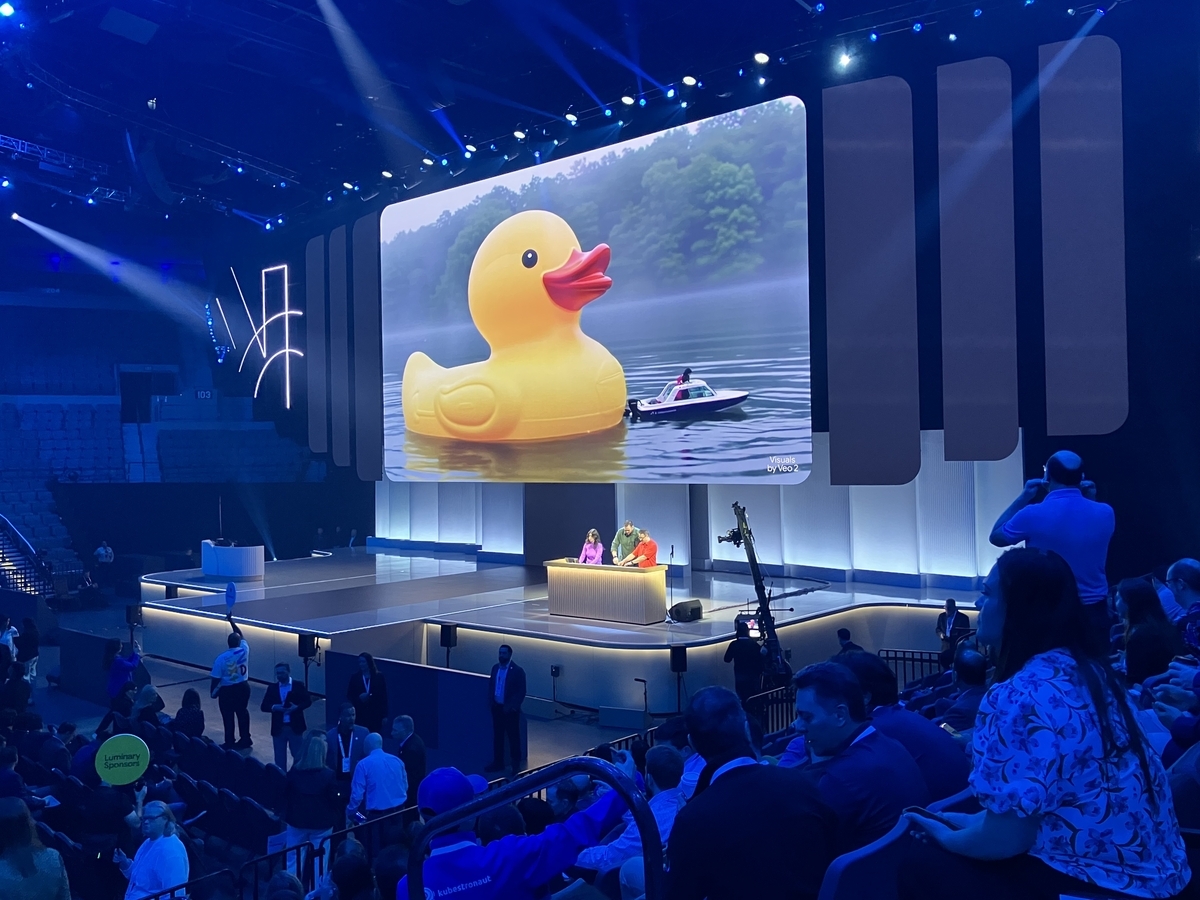

おまけ

Nextの思い出を1記事ずつ載せていきます。